蒸馏、量化、671B、满血版——大模型的这些名词都是什么意思

先来看看Deepseek模型的发展史——

2024 年 1 月发布 Deepseek-V1(67B),这是 Deepseek 第一个公开的开源模型。

2024 年 6 月发布 Deepseek-V2(236B)。新增了两个新颖的技术特色:多头注意力、MOE 专家混合,显著提升推理速度和性能,为 V3 奠定了基础。

2024 年 12 月发布 Deepseek-V3(671B),其参数量更为庞大,且能更好地在多 GPU 间平衡负载。

2025 年 1 月发布了 R1 系列模型:

Deepseek-R1-zero( 671B),这是一个推理模型(Reasoning Model),使用强化学习(Reinforcement Learning,简称“RL”)训练模型,使其能围绕目标自行探索。

Deepseek-R1( 671B),结合了强化学习和监督微调,推理效果极大提升,表现接近全球领先闭源模型 OpenAI 的 O1,而其运行成本相比O1降低了惊人的96%。

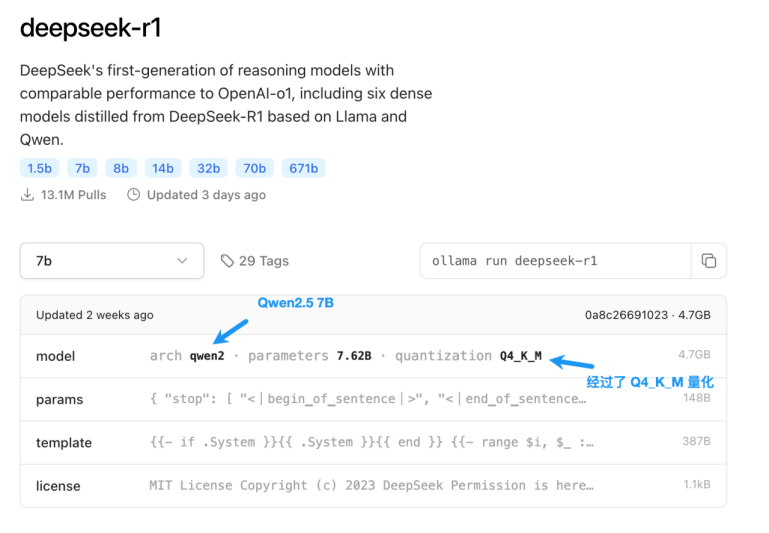

Deepseek-R1-Distill-Qwen/llama 系列,训练参数量有多种,是 Qwen2.5 和 Llama3 模型经过 R1 “调教” 后生成的推理模型,满足了更多企业轻量化需求。

2025 年 2 月,另一个模型研究团队 Unsloth 发布了基于 R1 的量化模型系列:

Deepseek-R1-GGUF 系列,GGUF 格式可以更紧凑地存放模型参数,减少磁盘占用空间,加速模型的启动与运行。

Deepseek-R1-Distill-Qwen/llama-Int4/Int8 系列,采用了低比特量化,将原本模型的数据精度降低到 4 bit或 8 bit,适用于资源受限的硬件环境。

从 Deepseek 模型的发展可以看出,R1 并非由某一种或两种训练方法堆积而成

而是从 V1 开始,经由多个版本的模型互相构建、融合多种训练方法、逐步进化而来

更值得称赞的是,DeepSeek-R1 秉持着开源精神,免费开放给全球开发者使用,让更多的研究人员、企业可以更低门槛使用先进的模型,推动了全球AI技术发展,被图灵奖得主、Facebook 首席人工智能科学家杨立昆称赞为 “开源战胜闭源”。

B是什么单位?

DeepSeek 模型的不同版本(如 1.5B、7B、14B、32B、70B)中的B

指模型的参数量

其中“B”代表“Billion”(十亿)

因此,当提到一个大模型有7B参数时,意味着这个模型包含了大约70亿个参数

参数量是衡量模型规模和复杂性的重要指标

B越大,AI模型的能力越强

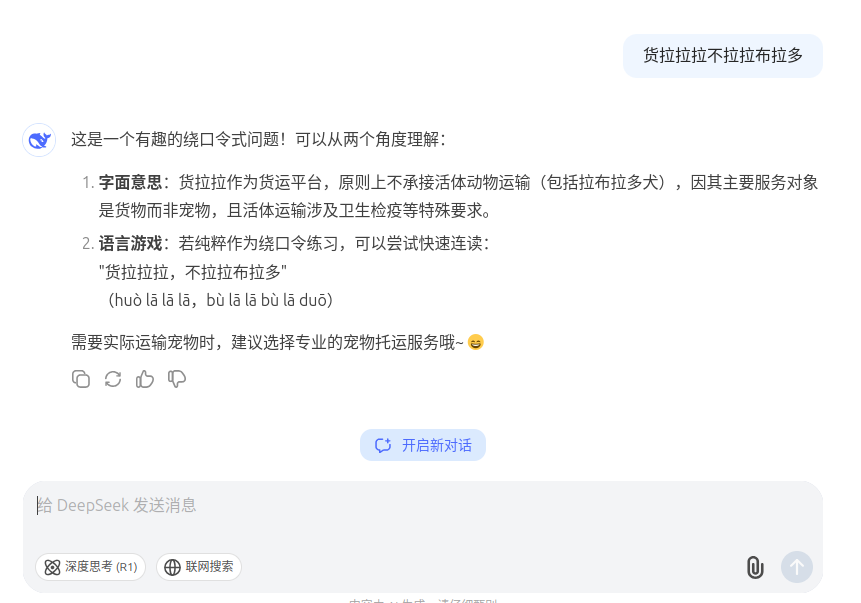

推理/非推理模型

推理模型(Reasoning model)

指 AI 领域能模拟人类逻辑思维与推理的模型。

例如 Deepseek - R1

它基于深度学习架构,融合多领域技术,经大量数据训练构建知识表征,运用强化学习在 “尝试 - 反馈” 中优化策略,在处理复杂问题时 主动探索、逻辑推导。

也就是大家常说的【深度思考】

可见在回答问题时,会有逻辑闭合的推理的过程

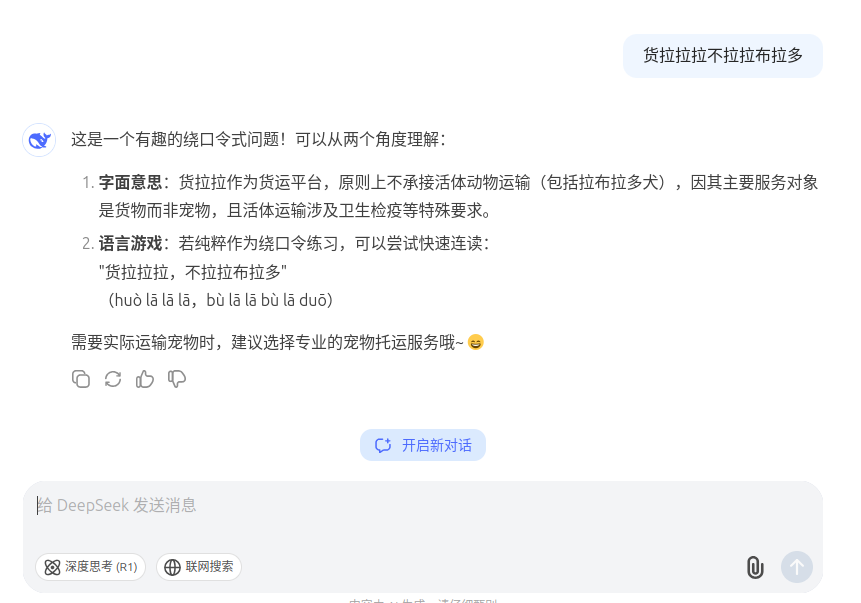

非推理模型

如 DeepSeek - V3

是大语言稠密模型,更多基于已学习到的语言模式和统计规律处理任务。

可见没有推理过程,由学习过的已知的信息来快速给予回答

蒸馏

真正的 DeepSeek-R1 为 671B 参数

因为Deepseek-R1的参数量非常大,部署要求非常高,为了在小参数模型中引入长思维链推理能力,DeepSeek 团队引入了蒸馏技术。

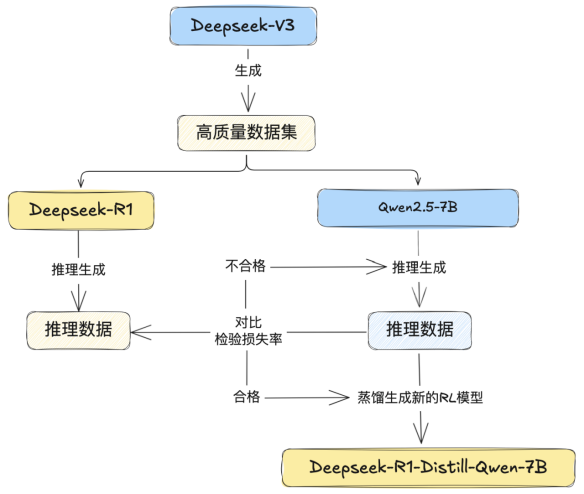

模型蒸馏就像是一场知识的传承,我们以 Deepseek-R1-Distill-Qwen2.5-7B 为例简单阐述蒸馏过程。

选择对象

首先选择一名优秀的学生Qwen,打算对它进行推理增强训练。强大的 R1会作为 “老师模型”,有着丰富的知识储备和卓越的推理能力。

准备工作

在蒸馏过程开启时,需准备大量训练数据,这些数据是模型学习的基础,随后将教师模型 R1 与学生模型 Qwen 同时置于训练环境中。

训练过程

教师模型 R1 对输入数据进行处理并生成输出,其输出包含了模型对数据特征的提取与理解。

学生模型 Qwen 在学习原始数据的同时,会通过损失函数计算自身输出与教师模型输出的差异,就像学生模仿老师解题思路一样,不断调整自身参数以最小化这种差异。

例如在分类任务中,教师模型输出各类别的概率分布,学生模型则努力模仿该分布,从而学习到教师模型的知识与推理模式。

经过多轮迭代训练,学生模型 Qwen 的推理能力得到显著提升,最终生成有推理能力的 Qwen 模型。

蒸馏的好处

从成本与效率角度看,小型模型经蒸馏后可具备接近大型模型的性能

降低企业部署成本,提高推理速度,减少对大规模计算资源的依赖

但它的本质上仍然是 Qwen 或 Llama,因此需要对模型进行仔细的理解和评测,才能满足实际的业务需求

量化

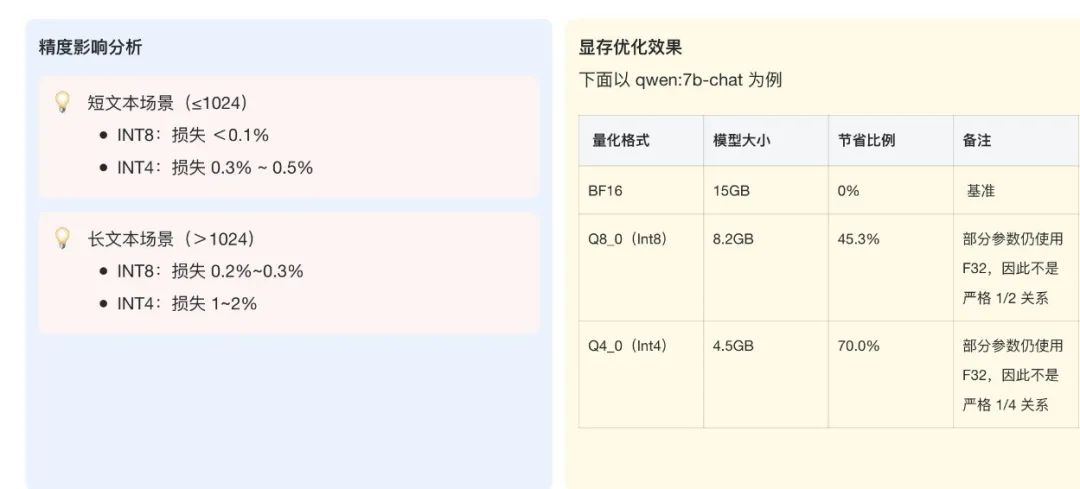

量化是指将模型中的权重和激活值从高精度(如 FP32、BF16)转换为低精度(如 INT8 或 INT4 等)表示的方法。

通过减少每个参数占用的位宽,可以显著降低模型的存储和计算需求。

量化模型可以大幅减少显存占用和计算量,使得在普通 GPU 甚至 CPU 上部署大型模型成为可能。

然而,过度的量化可能导致模型精度的下降,特别是在处理需要精确计算和推理的任务时。

在新的量化工具(例如 Llama.cpp)中,对于量化做了非常精细的处理, 例如对部分层做不同精度(4 位、6 位、32 位)的量化,因此还会衍生出 Q4_K_M、Q6 等各种量化,但本质上依然是精度、速度、资源占用之间的平衡。

思维链

有的时候模型还没有思考完成,但是后续就不再继续输出了

这是因为模型回答已经达到了其“最长输出”的上限。

对于 DeepSeek 的官方 API 来说,最大思维链长度为 32K,最大输出为 8K

就其原始模型来说,最大可以提供约 164K 的上下文,也就是大约能理解和输出总和差不多 10~16 万字。

上下文窗口:指模型在单次推理过程中能够处理的最大 Token 数量

但在提供超长上下文的背后其实是大量的资源消耗,因此一些 API 可能不会开放最大的输出和上下文能力。

对于以往的大部分非推理模型来说,可能 4K 的上下文足以满足单次对话的需求,但是对于推理模型来说,由于“思考”需要占用上下文,因此 4K 上下文可能连单次会话都不够用